Nuove controversie sulla censura di Facebook

Facebook sta rendendo sempre più trasparente la sua politica di rimozione di contenuti: proprio lo scorso anno ha reso consultabile una breve guida sugli Standard della Community, che riassume il lavoro effettuato ogni giorno da migliaia di moderatori. I paragrafi toccano vari punti, come l’incitazione all’odio, le immagini violente, la propaganda terrorista e la disinformazione.

“Vogliamo che le persone capiscano i nostri standard, vogliamo dare chiarezza” spiega Monika Bickert, Responsabile della Gestione Globale delle Politiche di Facebook, spiegando come stiano “cercando di tracciare il giusto confine tra sicurezza e libertà di espressione“.

La pubblicazione di queste linee guida ha finalmente permesso al social network di essere più vicino agli utenti, offrendo suggerimenti su come distinguere tra ironia, sarcasmo e incitazione all’odio. Sostanzialmente, tutto sta nel contesto: le immagini di nudo sono vietate per esempio, ma fanno eccezione quelle riguardanti l’allattamento o il tumore al seno.

La necessità di avere una politica ben definita sulla censura deriva anche da anni di critiche e ambiguità, soprattutto riguardo le testimonianze di razzismo e di guerra. In Italia anche il fumettista Michele Rech, meglio noto come Zerocalcare, si è ritrovato nel 2016 a fare i conti con la censura sul social. Al centro della polemica vi era il suo post sulla futura partecipazione a un’iniziativa in ricordo di Carlo Giuliani. Dopo aver ricevuto insulti e minacce per ore, al disegnatore è stata oscurata la pagina fino all’avvenuta rimozione del post.

I content moderators: chi sono, cosa fanno e perché sono gli eroi di cui abbiamo bisogno

Per mantenere Facebook “pulito”, i moderatori devono visualizzare ogni giorno centinaia di immagini e video segnalati, spesso riguardanti anche omicidi, stupri, pedofilia, violenze sugli animali.

“[I moderatori hanno] un lavoro difficile e impegnativo” conferma Facebook, “vogliamo assicurarci che i revisori siano in grado di prendere la decisione giusta, ma anche avere le risorse mentali ed emotive per rimanere in buona salute”.

Per quanto parte del sistema di censura sia automatizzato, molti ammettono di essersi ritrovati sopraffatti dalla quantità di post e impreparati al forte carico emotivo e psicologico, al punto da soffrire di ansia e stress post-traumatico. E se da un lato l’azienda ha offerto vari percorsi di consulenza psicologica, dall’altro i dipendenti li ritengono insufficienti per affrontare gli effetti collaterali causati dal visionare alcuni dei materiali più depravati su Internet, tanto da portarli a lasciare il lavoro mediamente entro un anno.

Il leak di documenti segreti

I moderatori ricevono due settimane di formazione e l’accesso ai manuali di normative disposti direttamente dai dirigenti di Facebook dalla sede centrale in California. Proprio questi documenti segreti sono stati leakati al quotidiano britannico The Guardian.

I documenti mostrano alcuni dei problemi che Facebook deve fronteggiare – dalle immagini di violenza al terrorismo – e la politica utilizzata, ovvero cosa va rimosso e perché.

Tuttavia le slide rivelano che le regole di Facebook spesso finiscono per far prevalere i diritti di chi detiene il potere sui più deboli.

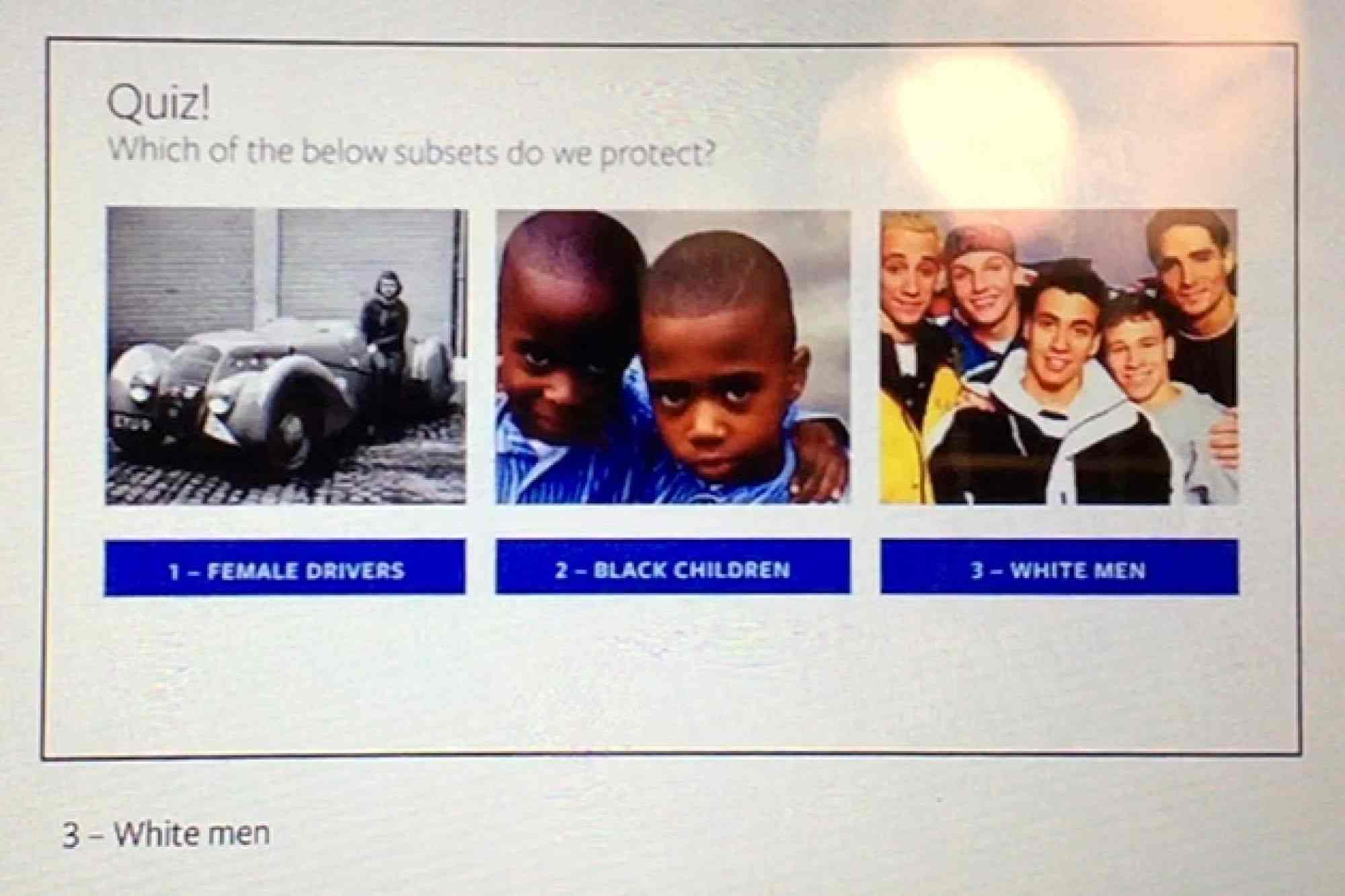

Facebook indica quindi ai moderatori di eliminare l’istigazione all’odio verso “categorie protette”, inclusi gli uomini bianchi, ma di ignorare gli attacchi a sottocategorie, come le guidatrici donne o i bambini di colore.

La giusitificazione è che “un linguaggio violento spesso non è credibile finché non è abbastanza specifico da farci credere che non ci sia più solo un’espressione, ma anche una transizione all’attuazione”.

Il leak ha riattivato il dibattito globale sul ruolo e l’etica del social network.

Accusa di pagine privilegiate

Un giornalista investigativo sotto copertura si è infiltrato alla CPL Resources, una delle società esterne a Facebook cui il social network affida la moderazione dei propri contenuti dal 2010.

Lavorando tra i moderatori di Facebook, ha potuto assistere personalmente al trattamento di favore di cui godono pagine dedite alla diffusione di fake news, contenuti violenti e messaggi razzisti. Tra queste ci sono anche pagine di estrema destra, che sarebbero state agevolate a “superare la soglia di rimozione“.

Il training ricevuto dal giornalista evidenzia come il lavoro, in realtà, tenda a una sostanziale tolleranza verso molti contenuti che violano le regole di Facebook.

“Se censuri troppo le persone perdono interesse, alla fine tutto si riduce a fare soldi”, così uno dei moderatori spiega il concetto alla base. Un istruttore invece chiede di sorvolare sull’età degli utenti: “abbiamo bisogno di un’ammissione [dall’utente] che non sia sufficientemente grande. Facciamo semplicemente finta di essere ciechi e di non sapere che aspetto abbia uno sotto i tredici anni”.

Facebook risponde con un “grazie”

La storia è stata raccontata in un documentario dal titolo “Inside Facebook: Secrets of the Social Network“, trasmesso su Channel 4 – la stessa emittente che pubblicò i video dei colloqui con i clienti dei dirigenti di Cambridge Analytica. Il video parla di approcci neutrali davanti a contenuti segnalati come violenti, razzisti e di incitamento all’odio.

Il Responsabile delle Politiche Pubbliche, Richard Allan, contesta:

“Se il contenuto sta effettivamente violando le regole deve essere rimosso. Ma il dibattito politico può essere del tutto legittimo. Penso che la gente si aspetterebbe da noi prudenza e cautela prima di eliminare le loro affermazioni politiche”.

In seguito, Facebook ha ringraziato l’emittente televisiva con un post sul suo blog, replicando che il training per i moderatori verrà aggiornato. Il social network, comunque, assicura che “chiunque non avesse aderito ai valori di Facebook non lavori più per la moderazione dei contenuti della piattaforma”.

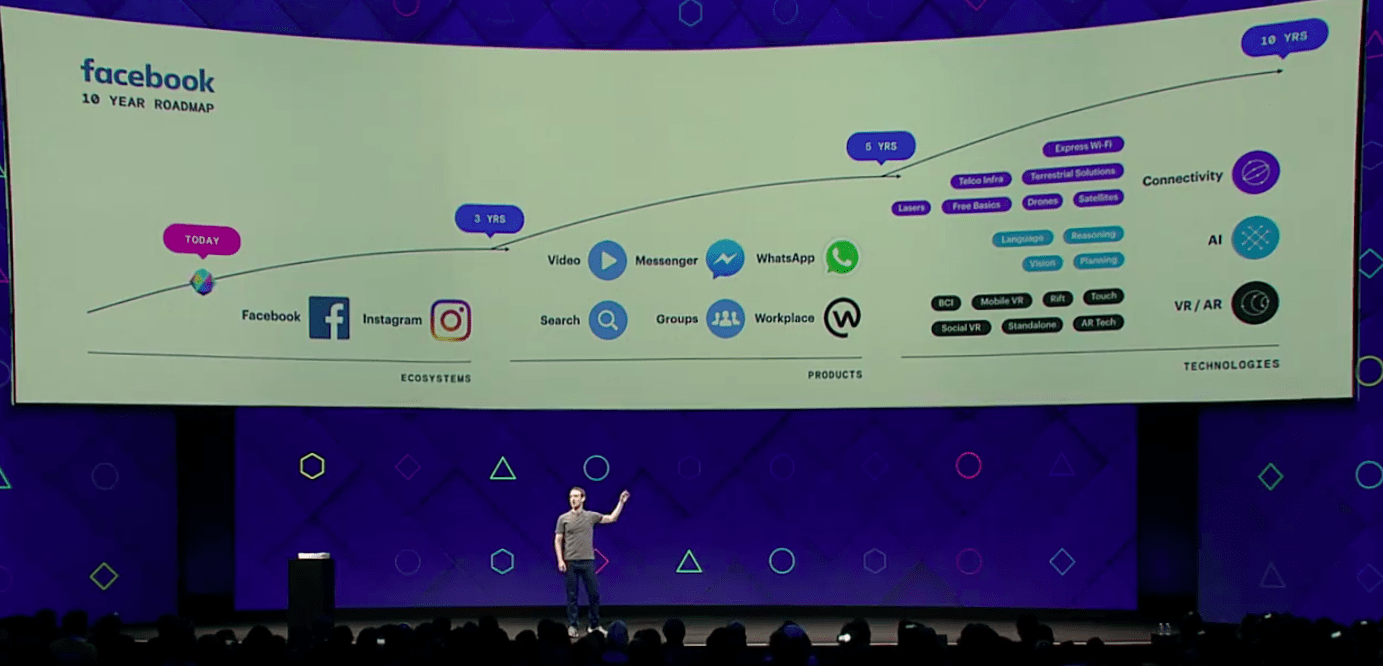

Il futuro della piattaforma

Un gruppo di 10,000 moderatori in ogni parte del mondo controlla post 24 ore al giorno, 7 giorni su 7, in più di 40 lingue; nella squadra anche personale specializzato, inclusi un avvocato per i diritti umani, un esperto di antiterrorismo e un esperto nelle organizzazioni estremiste.

Nonostante ciò, gli utenti si dicono frustrati dalla mancanza di motivazioni quando si vedono rimuovere un post – il messaggio che dovrebbe riportare le motivazioni è infatti molto generico.

Bickert cerca da anni un metodo per classificare automaticamente le ragioni dell’eliminazione dei post, sia per fornire informazioni agli utenti, sia per tracciare post inappropriati; e ogni due settimane i dipendenti e i dirigenti si incontrano per discutere sui vantaggi e sugli svantaggi di possibili politiche future.

Gli obiettivi più difficili

Facebook nell’ultimo anno ha subito molta pressione per combattere l’epidemia delle fake news. Monika Bickert spiega come non esista un’unica soluzione: la compagnia sta provando a puntare in varie direzioni, ottenendo risultati non sempre ottimali.

Tra i tentativi più recenti di sopprimere le notizie false vi è un sondaggio di due domande. I risultati del sondaggio sarebbero stati poi utilizzati per determinare l'”attendibilità” degli editori di notizie online. La principale critica dai media fu di semplificare eccessivamente, rischiando di incorrere in manipolazioni, anche all’interno di Facebook.

Il sondaggio chiedeva agli utenti di rispondere a due domande:

- Riconosci il seguente sito web? Sì,no.

- Quanto ti fidi di ciascuno di questi domini? Completamente, molto, abbastanza, poco, per nulla.

La prossima sfida per Bickert consisterà nel provare ad adattare un servizio nato per essere fluido e “senza confini” alle leggi dei vari Stati. Tenterà di integrare richieste dai vari governi per bloccare certi tipi di contenuti nei rispettivi Paesi, come l’istigazione all’odio in Germania.

Per rimanere informati sul mondo nerd, continuate a seguirci sul nostro sito DrCommodore.it e su Facebook, Instagram, Telegram, YouTube, Discord e Twitch.