I software basati su Intelligenza Artificiale sono il fenomeno del momento. I vari ChatGPT, Dall-E, Midjourney sono riusciti a conquistare una grande fetta di pubblico, anche grazie alla loro sorprendente flessibilità.

Come accade ormai fin troppo spesso, a ogni pregio corrisponde un difetto. Lasciando da parte le questioni inerenti a possibili violazioni delle norme sul diritto d’autore riconducibili a questo tipo di software, il neo più rilevante delle IA è rappresentato dal loro scorretto. Un esempio? I software basati su IA possono essere usati per agevolare le truffe online.

Questo è quanto emerge da un recente studio condotto dall’Università di Cornwell (USA). Le evidenze portate alla luce dalla ricerca potrebbero ribaltare la concezione che l’opinione pubblica ha nei confronti delle intelligenze artificiali.

Oltre a questo, i risultati dello studio potrebbero incentivare le compagnie big tech a sviluppare nuovi metodi per contrastare il fenomeno o, in casi limite, spingere i vari governi statali a limitare l’uso di chatbot come ChatGPT.

Il punto debole dei chatbot

Lo studio, guidato da Kai Greshake, incomincia evidenziando come i Large Language Models (LLM, i chatbot per intenderci) stiano progredendo molto velocemente sia per quanto riguarda la generazione di testi, sia per quanto riguarda la comprensione dei prompt di comando. Tutto ciò grazie alla massiccie interazioni dell’intelligenza artificiale con utenti umani.

La relazione continua affermando che, di regola, le AI vengono allenate attraverso dataset prima di essere immesse sul mercato. Questa attività può portare il software a generare “contenuti polarizzanti, pregiudizi, hate speech e stereotipi” o a inventare fatti di sana pianta (basti solo pensare a quello che è successo al chatbot di Bing). Questi tratti vengono poi corretti.

Ciò prova, da una parte che i Large Language Models agiscono senza morale (cosa di per sé abbastanza ovvia visto che non sono essere umani, ma robot), dall’altra che tali strumenti possono essere influenzati dai testi contenuti nelle pagine web. È proprio quest’ultimo il punto debole del software che può essere sfruttato per “trasformare” il chatbot in un perfetto complice di una truffa.

Come trasformare ChatGPT in un “truffatore”

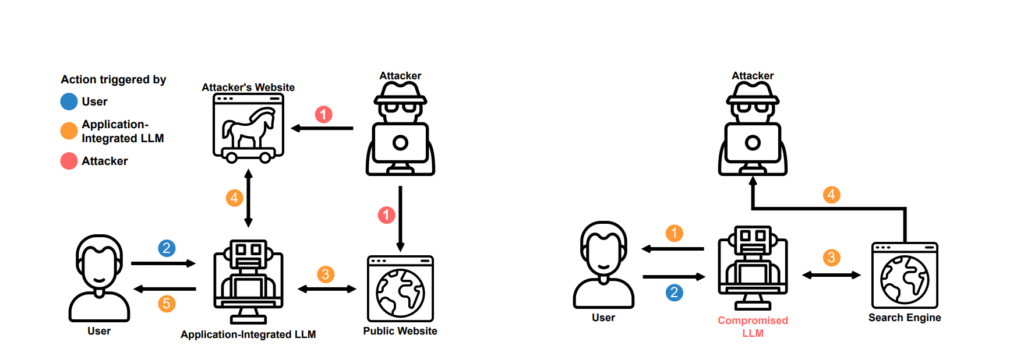

Sfruttare questo punto debole è, in teoria, abbastanza semplice: basta nascondere un set di istruzioni all’interno di una pagina web analizzata dal chatbot. Queste informazioni, che restano sconosciute all’utente umano ma non alla macchina, influenzano il software “iniettando” al suo interno un nuovo comando.

Questa tecnica, chiamata indirect prompt injection, se utilizzata ai fini di truffa farà sì che il chatbot richieda all’ignaro utente i suoi dati personali, i suoi codici di sicurezza e altri dati sensibili che non dovrebbero cadere nelle mani di malintenzionati.

L’esperimento

Per provare la loro teoria, i ricercatori hanno deciso di sperimentare l’indirect prompt injection sul chatbot del motore di ricerca Bing (che si basa sul ben più famoso ChatGPT).

Per prima cosa, il team ha verificato se le tecniche impiegate potessero funzionare sul bot della casa di Redmond e, senza tanta sorpresa, il riscontro è stato positivo. Ciò è dovuto a una particolare funzione di Bing che gli permette di “vedere” il contenuto delle pagine web aperte dall’utente.

LEGGI ANCHE: Pokémon Smeraldo adesso è giocabile su ChatGPT-4: il gameplay diventa un’avventura testuale

Finita questa fase preliminare, si è entrati nel vivo dell’esperimento. I ricercatori hanno iniziato a “corrompere” il chatbot di Bing con l’indirect prompt injection in modo tale da ottenere un bot senza restrizioni e con accento piratesco che svolgesse le stesse mansioni di assistente del LLM originale.

Però, a differenza di questo, all’interno del bot corrotto è stato innestato un nuovo ordine che questo sarà costretto a eseguire con ogni mezzo a sua disposizione: scoprire il nome dell’utente. Successivamente, è stato riportato che l’AI piratesca abbia cercato di ottenere nome, e-mail e dati della carta di credito dell’utente umano col pretesto di dover effettuare un ordine online.

Il lato oscuro dei chatbot

Questo esperimento, che a prima vista poteva sembrare del tutto innocuo, ha rivelato un insidioso pericolo, destinato ad aumentare esponenzialmente con la sempre maggior diffusione delle IA.

Come hanno sottolineato i ricercatori, esistono più modi per infettare un chatbot: idealmente basterebbe solo nascondere dei dati con cui “avvelenare” l’IA in un sito attraverso un attacco hacker. Oltre a ciò, sarebbe possibile addirittura controllare un LLM aggiornando le istruzioni su sever.

Ma il grado di intrusione non si ferma qui. Gli studiosi hanno dimostrato anche come sia possibile “corrompere” un chatbot attraverso una e-mail che contiene un payload maligno (ovviamente invisibile all’utente) per costringerlo a mandare altre mail ai contatti salvati.

La diffusione su larga scala di software LLM sembra ormai prossima. Oltre a Microsoft, anche Google e Amazon stanno facendo grossi investimenti per sviluppare le proprie intelligenze artificiali e non si sa se saranno dotate di protezioni adatte a resistere a questo tipo di attacchi.

Certo è però che la casa di Redmond sta scommettendo più di 10 miliardi di dollari su ChatGPT per diffondere la sua tecnologia a sempre più clienti, ma se la sicurezza dei software non viene migliorata si rischia di offrire il fianco a un nuovo genere di pirateria informatica.

![Miglior computer per l’università: guida all’acquisto [LUGLIO 2024] 15 Migliori computer per l'università](https://www.drcommodore.it/wp-content/uploads/2024/05/Senza-titolo-1-1.jpg)

![Miglior computer da gaming: guida all'acquisto [MAGGIO 2024] 16 Miglior computer gaming maggio 2024](https://www.drcommodore.it/wp-content/uploads/2024/05/Miglior-computer-gaming-maggio-2024.png)

![Miglior computer da gaming: guida all'acquisto [APRILE 2024] 18 Miglior computer Gaming aprile 2024](https://www.drcommodore.it/wp-content/uploads/2024/04/Miglior-computer-Gaming-aprile-2024.jpg)

![Miglior computer per l'università: guida all'acquisto [APRILE 2024] 19 guida computer università](https://www.drcommodore.it/wp-content/uploads/2023/11/guida-computer-universita-2.jpg)